Quantized Side Tuning 논문 리뷰

Quantized Side Tuning: Fast and Memory-Efficient Tuning ofQuantized Large Language Models 논문에 대한 리뷰를 작성한 글입니다.

2025/03/11

Jinsoolve.

(46)

2025/04/27

Cross Entropy와 Softmax

2025/04/27

Word2Vec과 GloVe의 차이는 무엇일까?

2025/04/25

Batch Normalization을 하는 이유는 뭘까?

2025/02/20

삼격형의 두 변의 길이와 사잇각을 알 때, 나머지 한 변의 길이를 구하는 공식

2025/02/10

c++에서 내림차순에 대한 lower_bound와 upper_bound하기

2025/01/13

C++에서 이진수의 비트 수를 세는 방법

2025/01/13

세 점의 좌표가 주어졌을 때 삼각형의 면적 구하는 방법

2025/01/09

표준화와 정��규화

2024/12/26

로지스틱 회귀의 비용 함수는 왜 이렇게 생겼을까?

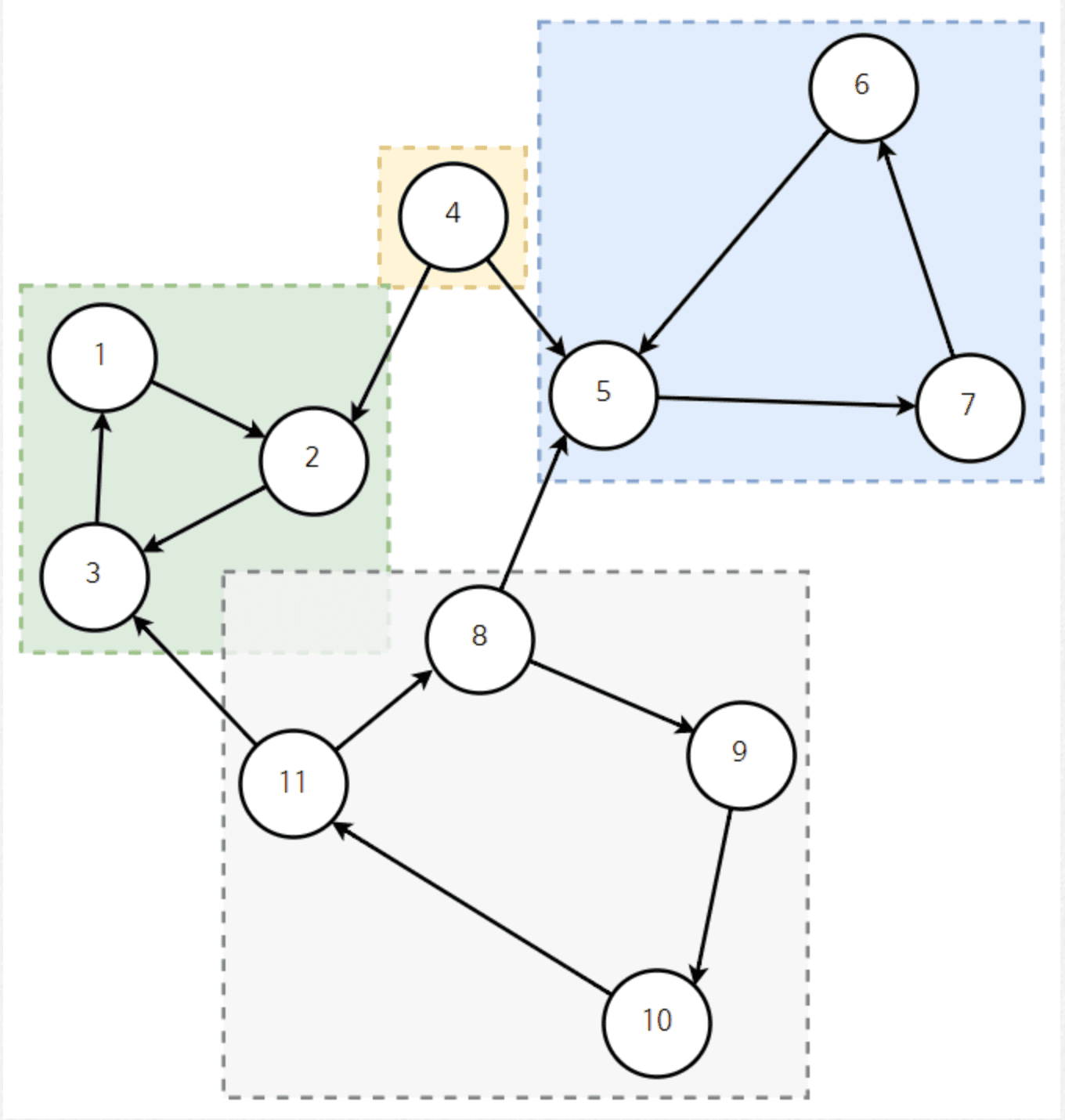

SCC에 대한 알고리즘 포스트입니다.

2025/08/29

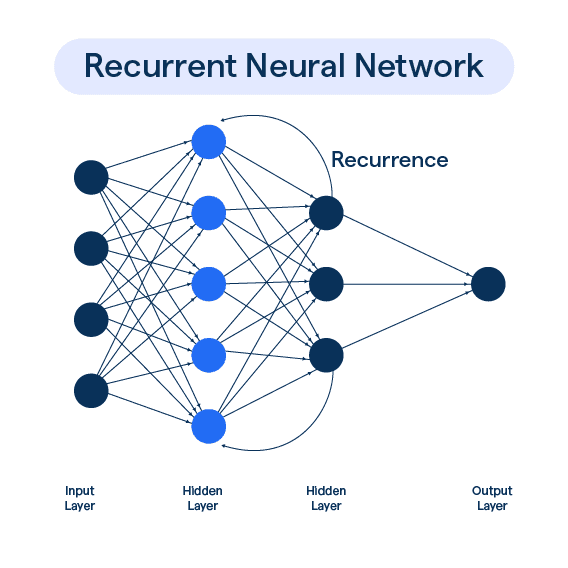

Seq2Seq에서 RNN을 아예 빼버리고 attention으로 구성해보면 어떨까? → Transformer의 구조 현재는 seq2seq + attention에서는 하나의 벡터로…

2025/04/27

성# Language Model(LM)이란? 언어 모델이라는 건, 사실 다음에 올 단어를 확률로 예측하는 것이다. 이러한 언어 모델들을 어떻게 발전시켜왔는 지 살펴보자. 이미 이…

2025/04/27

이전 포스트에서 RNN에서 Vanishing Gradient로 인해 장기 의존성 문제가 있다는 사실을 이야기했다. 이런 Vanishing Gradient를 해결하기 위해 크게…

2025/04/27

기존 RNN의 병목 현상을 해결하기 위해 Attention이 등장했다. Decoder에서 한 단어를 예상할 때, 해당 단어와 특별히 관련되어 있는 Encoder의 특정 단어를…

2025/04/27

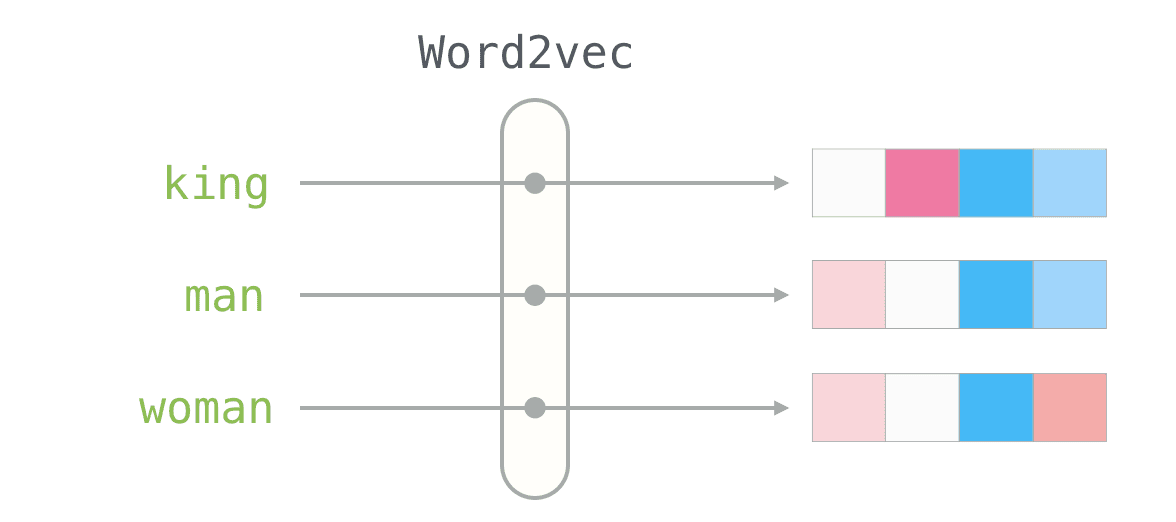

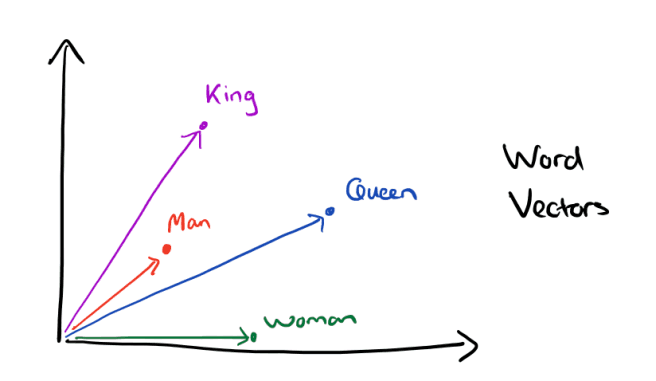

저번에 word vector에 대해서 알아봤는데, 이번에는 word vector의 프레임워크인 Word2Vec에 대해서 좀 더 알아보자. 먼저 Word2Vec이 어떤 식으로…

2025/04/26

이번 포스트에서는 Word Vector에 대해서 알아보자. 먼저 아래와 같은 고민을 해보자. 우리는 어떻게 컴퓨터에게 단어의 뜻을 이해시킬 수 있을까? WordNet?# 예전에…

2025/04/25

위 포스트는 백준 28129 - 2022 APC가 어려웠다고요?의 풀이입니다. dp[i][j] := i번째 수가 j가 되는 경우의 수 dp[i][j]=∑k=max(j−k,a[i−…

2025/03/28

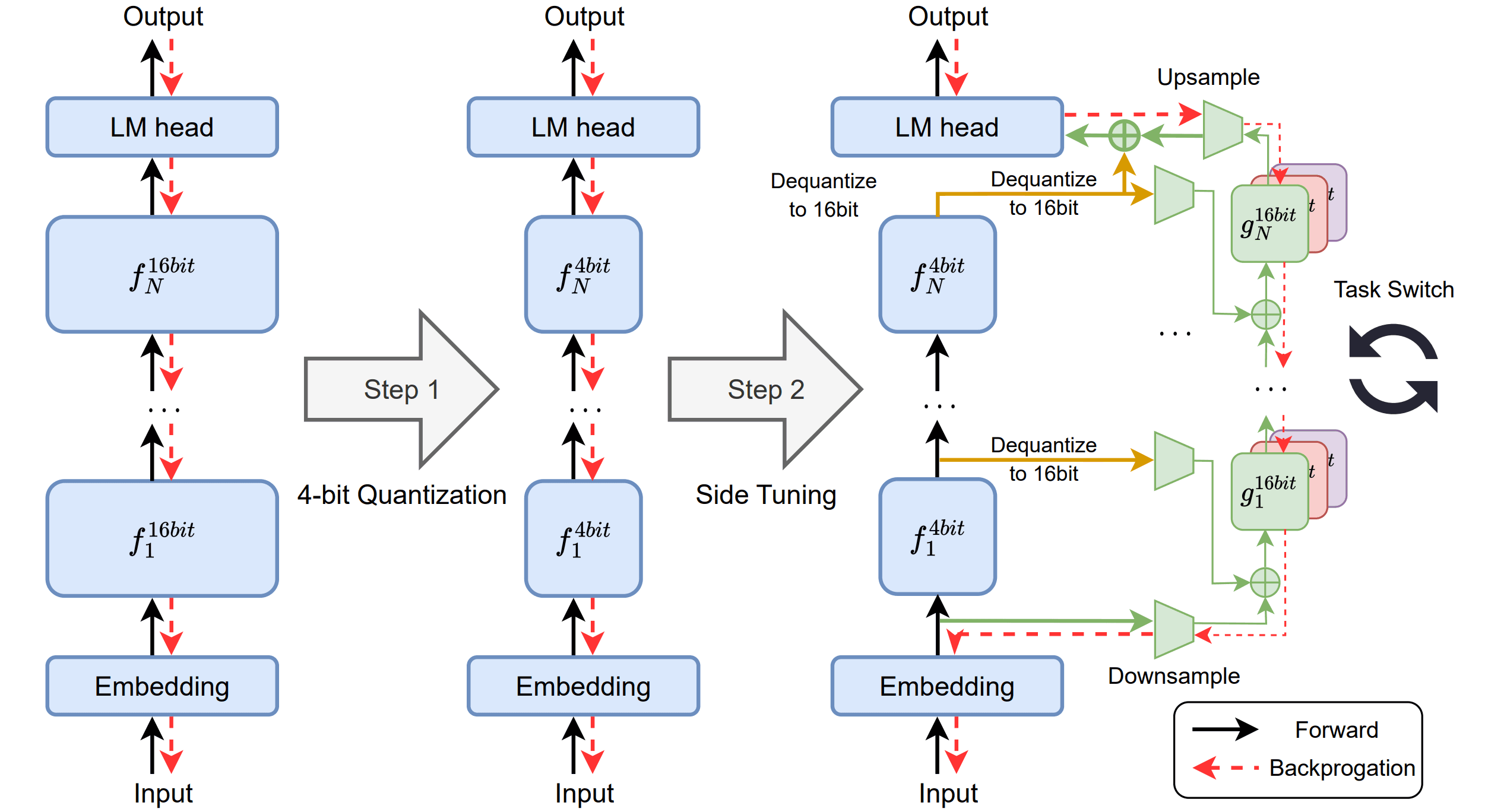

Quantized Side Tuning: Fast and Memory-Efficient Tuning ofQuantized Large Language Models 논문에 대한 리뷰를 작성한 글입니다.

2025/03/11