Batch Normalization을 하는 이유는 뭘까?

각 batch 데이터마다 분포가 다르게 되면 모델의 학습이 어렵다. 즉, 전에는 0 ~ 20 데이터가 들어와서 그거대로 학습했는데, 이번 batch에는 2000 ~ 4000…

2025/04/25

Jinsoolve.

(46)

각 batch 데이터마다 분포가 다르게 되면 모델의 학습이 어렵다. 즉, 전에는 0 ~ 20 데이터가 들어와서 그거대로 학습했는데, 이번 batch에는 2000 ~ 4000…

2025/04/25

위 포스트는 백준 28129 - 2022 APC가 어려웠다고요?의 풀이입니다. dp[i][j] := i번째 수가 j가 되는 경우의 수 dp[i][j]=∑k=max(j−k,a[i−…

2025/03/28

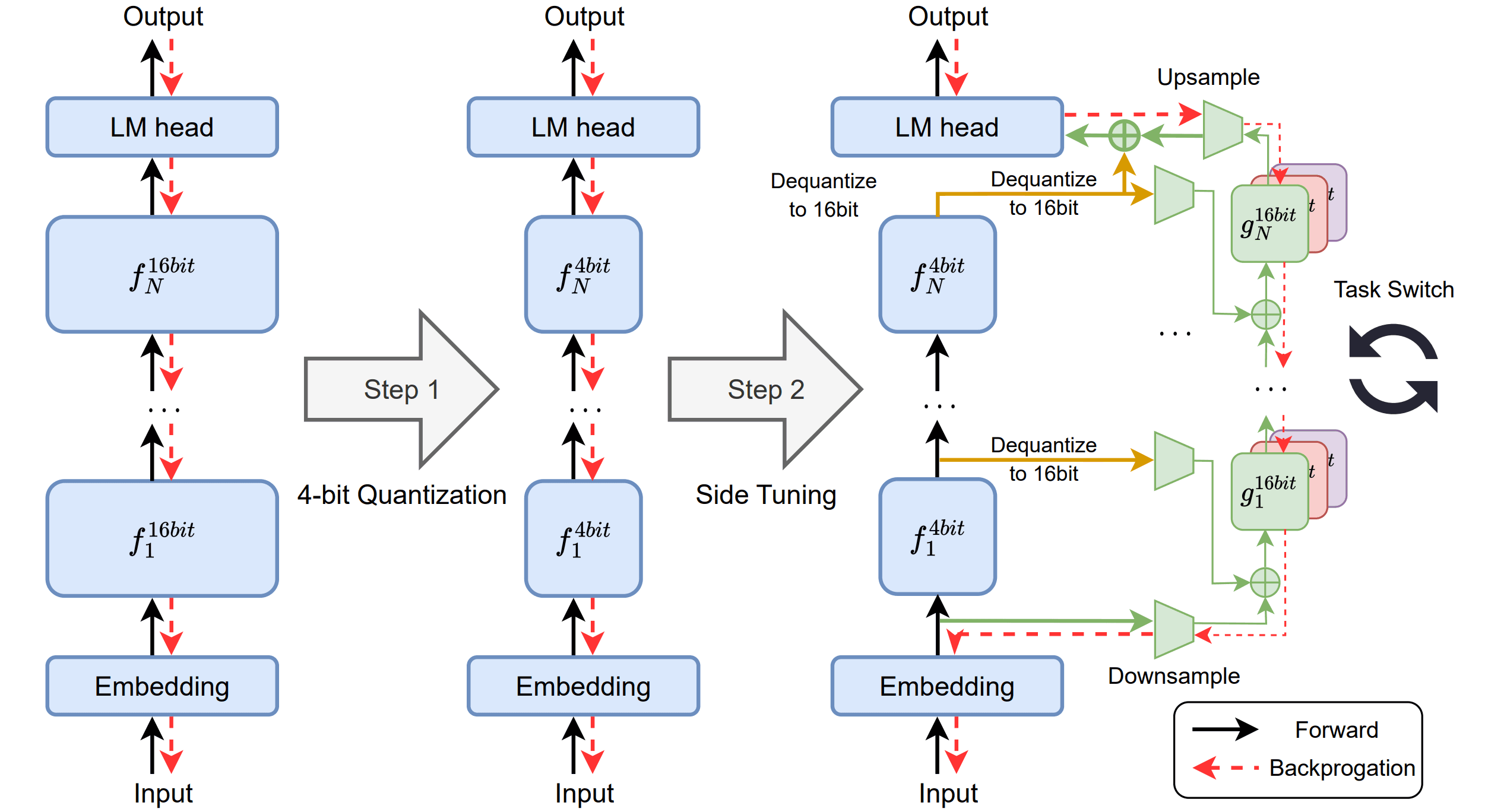

Quantized Side Tuning: Fast and Memory-Efficient Tuning ofQuantized Large Language Models 논문에 대한 리뷰를 작성한 글입니다.

2025/03/11

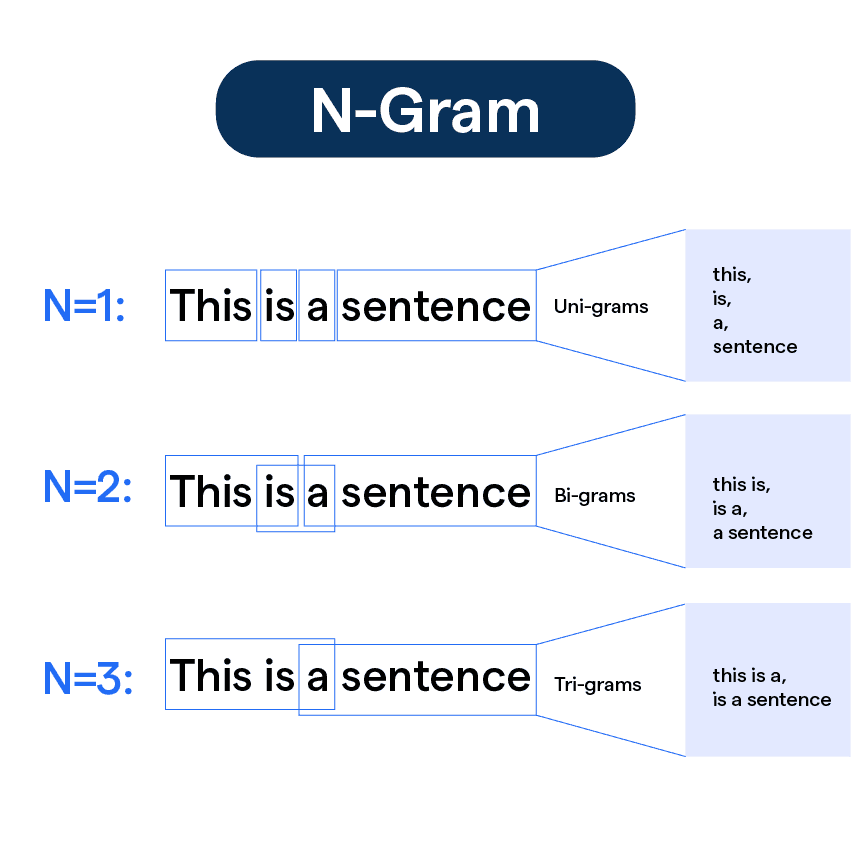

언어 모델이란, 결국에는 그 다음으로 어떤 단어가 오는 것이 가장 자연스러운지를 확률로 보고 가장 높은 확률의 단어를 선택해서 문장을 구성하는 방식이다. 위 포스트에서는 n…

2025/03/10

위 포스트는 백준 1055 - 끝이없음의 해설입니다. 문자열이 재귀적으로 반복하는 것을 알 수 있다. 이때 min과 max의 차이가 최대 100개 정도임을 알 수 있고, 우리는…

2025/03/05

위 포스트는 백준 1787 - 문자열의 주기 예측 의 해설입니다. 결국 부분 문자열에서 가장 짧으면서 일치하는 Prefix와 Suffix를 찾으면 된다. (해당 길이를 전체…

2025/03/05

위 포스트는 백준 8872 - 빌라봉 문제의 해설입니다. 위 문제에는 여러 개의 트리가 존재한다. 임의의 2개의 트리를 서로 이을 때 최대 시간이 최소가 되게 하기 위해서는 각…

2025/03/04

위 포스트는 백준 24979 - COW Operations에 대한 해설입니다. 아이디어1# 주어진 Operation을 해보면 아래와 같은 변환이 가능하다는 것을 알 수 있다.…

2025/02/28

위 포스트는 백준 6569 - 몬드리안의 꿈에 대한 해설입니다. ... ... ... ... ... ... ... ... 채워짐 채워짐 채워짐 채워짐 채워짐 채워짐…

2025/02/28